Wie sinnvoll sind 240 Hz statt 60 Hz oder hohe Frameraten? Welchen Einfluss hat V-Sync und was bringt Nvidias Reflex? Wir haben Antworten.

Wie flüssig ein PC-Spiel auf Grafikkarten oder Prozessoren läuft, wird in Bildern pro Sekunde gemessen; darunter fallen längst auch die Frametimes. Tatsächlich entscheidet aber noch ein weiteres Kriterium, ob sich ein Titel rund anfühlt oder nicht: die Latenz vom Klick bis zur Umsetzung im Spiel - und das testen wir heute.

Die Latenz beim Gaming basiert auf einer Vielzahl von Hardware- und Software-Komponenten, die alle ihren Teil zur Verzögerung beitragen. Wir zeigen auf, was höhere Bildraten, höhere Display-Frequenzen, eine variable Refresh-Rate, ein Frame-Limiter, die Anti-Lag-Optionen im Treiber und Nvidias Reflex bringen.

Um die Zeit von der Eingabe per Maus bis zum finalen Resultat auf dem Display zu messen, brauchte es bisher ein modifiziertes Eingabegerät und eine (Smartphone-)Kamera, die rund 1.000 Bilder die Sekunde aufzeichnen kann. Das so gefilmte Material wird Frame für Frame ausgewertet, was komplex und vor allem äußerst zeitaufwendig ist.

LDAT macht Latenzen messen einfacher

Diesen Aufwand wollte ein Nvidia-Mitarbeiter verringern, weshalb er als Nebenprojekt etwas entwickelt hat, was der Hersteller als LDAT (Latency & Display Analysis Tool) bezeichnet. Das Gerät ist kaum so groß wie eine Streichholzschachtel. Es wird per Gummiband am Monitor befestigt und enthält einen Helligkeitssensor, dessen Daten über USB an die dazugehörige Software übermittelt werden.

Uns liegt das LDAT v2 vor, welches nicht mehr zwingend auf eine modifizierte Maus angewiesen ist, sondern per Knopfdruck als solche agiert. Alternativ wird ein Mikrofon angeschlossen, um den Klick einer Maus als Eingabe zu registrieren. Die Software unterstützt praktischerweise eine Auto-Fire-Option, so können wir mehrere Magazine verfeuern und innerhalb kürzester Zeit Hunderte Samples anfertigen.

Vom Klick bis zum Mündungsfeuer

Die Ende-zu-Ende-Latenz, auch als System-Latenz bezeichnet, gibt LDAT in Millisekunden live als Diagramm mit Gauß'scher Normalverteilung aus. Neben einer durchschnittlichen Angabe erfasst die Software den minimalen sowie den maximalen Wert und gibt auch die Standardabweichung an. Diese ist wichtig, um die Streuung der Resultate in einem Intervall zu erfassen - je geringer die Abweichung, desto besser für die Latenz.

Einfach LDAT an den Monitor zu hängen und loszulegen, klappt zwar prinzipiell. Damit aber die Messungen möglichst konsistent sind, gilt es beim Testsystem, einige Punkte zu beachten und zu verstehen, wie die System-Latenz vom Klick bis zum Mündungsfeuer überhaupt zustande kommt.

Der CPU-Takt sollte möglichst fix und der verwendete USB-Port idealerweise direkt an den Prozessor statt an den Chipsatz angebunden sein. Wir verwenden daher einen achtkernigen Ryzen 7 5800X, auch die Corsair-MP-600-SSD hängt per PCIe Gen4 an der CPU. Als Display kommt ein Samsung Odyssey C27G7 mit 1440p und 240 Hz zum Einsatz, angeschlossen ist es an eine Geforce RTX 3070 als Founder's Edition.

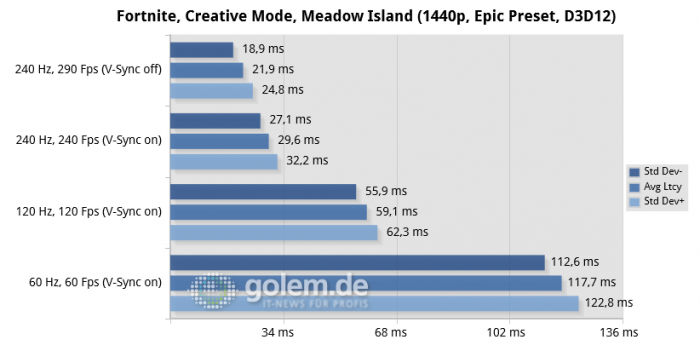

Um zu prüfen, welchen Einfluss die Frequenz des Displays auf die Latenz hat, reicht es bereits, den Windows-Desktop zu vermessen. Ausgehend von 60 Hz (42 ms) über 120 Hz (26 ms) bis hin zu 240 Hz (17 ms) reduziert sich die Verzögerung signifikant. Wer nun anmerkt, dass doch schon bei 60 Hz theoretisch 16,7 ms anliegen sollten, hat die Rechnung ohne das restliche System und ohne den Desktop Window Manager (DWM) gemacht.

Der arbeitet mit vertikaler Synchronisation (V-Sync), sprich bei 60 Hz liegen 60 Bilder pro Sekunde an. Diese werden zudem doppelt gepuffert. Aufgrund dieses Double-Buffering wird das Zerreißen (Tearing) des Bildes auf dem Desktop verhindert, weil die Grafikkarte aber auf das Display warten muss, steigt die Latenz an.

V-Sync verursacht Lag

In Spielen ist das - wenig überraschend - nicht anders, wie unsere Messungen zeigen. Um genügend Varianz zu haben, nutzen wir drei Titel: Call of Duty Warzone mit IW 8.0 Engine, Fortnite mit Unreal Engine 4 und Rainbow Six Siege mit Anvil Next 2.0 Engine. Bei Ersterem erfassen wir per LDAT das Mündungsfeuer und bei den anderen beiden ein aufblitzendes weißes Quadrat, was von den Entwicklerstudios zur Latenzmessung eingebaut wurde.

Nach der Mauseingabe durchlaufen diese Daten eine lange Pipeline: Vom Betriebssystem über die Game-Engine sind diverse CPU-Berechnungen nötig, damit eine Render-Queue für die Grafikkarte erstellt und von dieser abgearbeitet werden kann. Schlussendlich findet das Scanout für die Bildausgabe auf dem Display statt, was ebenfalls einige Zeit braucht.

Um die System-Latenz insgesamt zu drücken, gibt es beim letzten Glied in der Kette zwei grundlegende Optionen, von denen sich eine bei jedem Monitor - egal ob Gaming oder nicht - anwenden lässt. Die erste ist schlicht, V-Sync zu deaktivieren und Tearing in Kauf zu nehmen. Das sieht jedoch unschön aus und im schlimmsten Fall geht durch die entstehenden Bildfehler ein Schuss daneben.

Adaptive Sync verhindert Tearing

Alternativ kann Freesync (AMD) respektive G-Sync (Nvidia) genutzt werden, weil hier die Display-Frequenz an die Bildrate angepasst wird und nicht umgekehrt. Der finale Scanout erfolgt allerdings unabhängig von der variablen Refresh-Rate mit der maximalen Frequenz des Panels, weshalb 60 Fps bei sagen wir 240 Hz mit Adaptive Sync eine niedrigere Latenz ergeben als bei fixen 60 Hz.

Werden mehr Frames pro Sekunde gerendert als das Display an Hz aufweist, gibt es jedoch wieder Tearing - sofern nicht bewusst die vertikale Synchronisation zugeschaltet wird (und sich ergo auch die Latenz wieder erhöht). Um dieses Verhalten zu umgehen, bietet sich ein sogenannter Frame-Limiter an.

Ein solcher Fps-Begrenzer macht genau das, was seine Bezeichnung impliziert und limitiert die Bildrate auf einen gewünschten Wert. Liegt dieser leicht unterhalb der Adaptive-Sync-Obergrenze, gibt es überdies kein Tearing und auch keinen V-Sync-Lag.

Ein Frame-Limiter reduziert - richtig angewandt - die Latenz wie kaum eine andere Option: Besagte Render-Queue bei der Grafikkarte füllt sich immer dann, wenn eine Spielszene primär GPU-limitiert ist.

In diesem Fall kann die CPU in aller Ruhe die notwendigen Daten vorbereiten, weil die Grafikkarte ohnehin erst noch ältere Frames abarbeiten muss. Wird die Bildrate auf einen Wert begrenzt, der unterhalb derer liegt, welche die GPU erreicht, verkürzt das die Render-Queue und somit die Latenz drastisch.

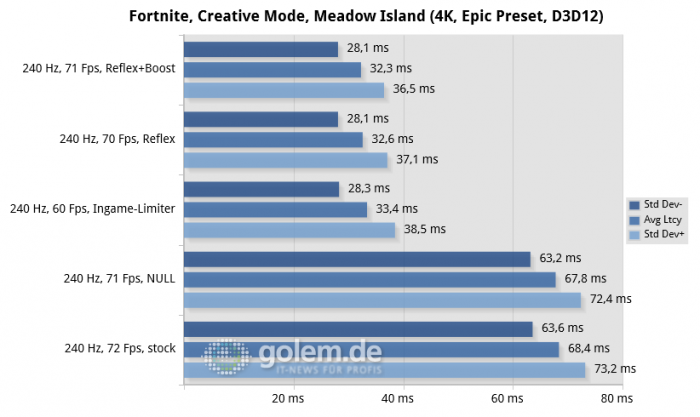

Das klappt zwar gut mit Tools wie dem RTSS (Rivatuner Statistics Server) des MSI Afterburner, allerdings erhöhen solche externen Apps die Latenz selbst leicht, wenn damit ein Fps-Limit gesetzt wird. Das gilt auch für Treiber-basierte (seit Geforce 441.87 bei Nvidia) Frame-Limiter, weshalb eine Ingame-Option die beste Wahl ist. Eine solche haben vor allem kompetitive E-Sports-Titel integriert, etwa Fortnite oder Overwatch.

Frame-Limiter sind starr

Als Problem bleibt jedoch, dass Spiele dynamisch sind - in einer Szene erreicht ein System etwa 70 fps, in einer anderen hingegen 100 fps. Da höhere Bildraten außerdem ebenfalls die Latenz verringern, gehen durch ein bewusst niedrig angesetztes Limit von beispielsweise 60 fps in unserem Szenario einige wertvolle Millisekunden verloren. Sollte die Bildrate darunter fallen, erhöht sich zudem der Lag wieder.

AMD und Nvidia bietet daher in ihren Treiber-Panels passende Optionen, um die Render-Queue von zwei bis drei Frames auf einen oder null zu kürzen: Radeon Anti Lag und Nvidia Ultra Low Latency (NULL) reduzieren im GPU-Limit die Latenz, sind aber längst nicht so effektiv wie eine Frame-Begrenzung. Wünschenswert wäre das Beste aus beiden Welten - und das gibt es tatsächlich in wenigen ausgewählten Titeln.

Nvidia Reflex arbeitet dynamisch

Die Technik nennt sich Reflex und funktioniert auf Nvidia-Karten ab den Geforce GTX 900 (Maxwell v2), auch in Kombination mit G-Sync. Das per SDK in Spiele zu implementierende Verfahren eliminiert die Render-Queue und nutzt einen dynamischen Frame-Limiter, welcher die Bildrate ein paar Frames unterhalb dessen drosselt, was die Grafikkarte im Stande zu leisten wäre.

Im GPU-Limit reduziert Reflex die Latenz drastisch, wobei sich die paar verlorenen Bilder pro Sekunde per Boost-Zusatz wieder reinholen lassen. Dabei wird die Grafikkarte in den höchsten P-State versetzt (was auch per Treiber geht) und die GPU minimal übertaktet. Das ist gerade so messbar, an der Latenz aber ändert sich fast nichts. Ist NULL aktiviert, erhält verständlicherweise Reflex den Vorzug.

Fassen wir zusammen, wie sich die Ende-zu-Ende-Latenz verringern lässt:

- Vertikale Synchronisation deaktivieren

- Möglichst hohe Framerate nutzen

- Display mit hoher Frequenz verwenden

- Freesync oder G-Sync einschalten

- Bildrate per Tool oder ingame begrenzen*

- Mit Radeon Anti Lag oder NULL spielen

- Nvidia Reflex bei unterstützten Titeln

*2-3 Fps unterhalb der Grenze von Adaptive Sync

Disclaimer: Dieser Artikel stützt sich anteilig auf die Vorarbeit von Battle(non)sense und Blurbusters, welche die Latenz-Thematik seit Jahren intensiv untersuchen.

https://ift.tt/2S5NEuN

Wissenschaft & Technik

Bagikan Berita Ini

0 Response to "LDAT v2 im Test: Der Gaming-Latenz auf der Spur - Golem.de - Golem.de"

Post a Comment